1. Warum KI-Sprachmodelle 2025 für Unternehmen entscheidend sind

Die Integration von KI-Sprachmodellen wie GPT-4, Claude oder Gemini in Unternehmensprozesse ist 2025 nicht mehr optional, sondern strategisch notwendig. Unternehmen, die auf Effizienz, Geschwindigkeit und Skalierbarkeit setzen, nutzen diese Modelle längst für zentrale Aufgaben im Tagesgeschäft. Besonders im Mittelstand eröffnen sich durch den gezielten Einsatz konkrete Vorteile: Texte werden schneller erstellt, Kundenanfragen automatisiert beantwortet, interne Dokumentation beschleunigt und komplexe Prozesse intelligent unterstützt.

Die Anwendungsfelder sind vielfältig. Im Marketing schreiben KI-Modelle in wenigen Sekunden suchmaschinenoptimierte Landingpages, Blogartikel oder Social-Media-Posts – abgestimmt auf Zielgruppe und Tonalität. Gleichzeitig lassen sich Produktbeschreibungen automatisiert generieren und in mehreren Sprachen ausspielen. Auch im Kundenservice sind die Fortschritte deutlich: Chatbots übernehmen 24/7 die Beantwortung von Standardanfragen, priorisieren Tickets oder liefern empathisch formulierte Rückmeldungen auf Basis von Gesprächsverläufen. Unternehmen, die diese Systeme gut trainieren, reduzieren die First-Response-Zeit drastisch – bei gleichzeitig verbesserter Kundenzufriedenheit.

Im Vertrieb unterstützen Sprachmodelle bei der Generierung personalisierter E-Mail-Texte, fassen Leads zusammen oder erstellen pitchfähige Präsentationen auf Basis von Stichworten. Das spart Zeit und hilft insbesondere in kleinen Teams, professionell und schnell zu agieren. Auch in der Softwareentwicklung zeigt sich der Nutzen: Entwickler erhalten Code-Vorschläge, Dokumentationen und Testfälle automatisch. So entstehen weniger Fehler – und mehr Zeit für kreative Architekturentscheidungen. Im Bereich HR und Verwaltung wiederum helfen Sprachmodelle dabei, Bewerbungen zu analysieren, Stellenanzeigen zu erstellen oder interne Wissensdatenbanken intelligent zu durchsuchen.

Kurz gesagt: Wer 2025 wettbewerbsfähig bleiben will, sollte jetzt beginnen, die passenden Modelle und Use-Cases im eigenen Unternehmen zu identifizieren. Sprachmodelle sind kein Selbstzweck – aber ein wirkungsvolles Werkzeug, wenn sie richtig eingesetzt werden.

2. Die führenden KI-Sprachmodelle im Überblick

Der Markt für KI-Sprachmodelle ist 2025 breit aufgestellt – und unübersichtlich. Neben den großen US-Anbietern wie OpenAI, Google und Anthropic drängen zunehmend europäische und Open-Source-Modelle in die Unternehmenspraxis. Doch nicht jedes Modell ist für jeden Anwendungsfall geeignet. Wer KI gewinnbringend einsetzen will, muss die Stärken und Schwächen der wichtigsten Systeme kennen. Hier ein praxisnaher Überblick.

2.1. GPT-4 von OpenAI: Der leistungsstarke Allrounder

GPT-4 gilt als Branchenstandard und ist über Microsoft (Azure OpenAI) tief in Office, Teams und Copilot-Produkte integriert. Es überzeugt durch hohe Textqualität, präzises Sprachverständnis und umfangreiche Plugins. In der Variante „GPT-4 Turbo“ erlaubt es eine Kontextlänge von bis zu 128.000 Tokens – ideal für komplexe Vorgänge, z. B. juristische Dokumentenanalyse oder umfangreiche Datenverarbeitung. Die API ist stabil, aber kostenpflichtig. Datenschutzkonformität ist nur bei Azure-Einsatz vollständig gewährleistet.

2.2. Gemini 1.5 von Google: Kontextstärke aus dem Webgiganten

Google spielt mit Gemini seine größte Stärke aus: das Verständnis kontextreicher Inhalte in extrem langen Dokumenten. Gemini 1.5 kann bis zu 1 Million Tokens verarbeiten und eignet sich daher besonders für tiefgehende Analysen oder die Auswertung ganzer Webseiten. In der Google-Welt integriert es sich nahtlos in Workspace (Gmail, Docs, Drive). Für Entwickler steht eine API bereit – allerdings ist das Modell aktuell nicht in der EU gehostet und daher nur bedingt DSGVO-tauglich.

2.3. Claude 3 von Anthropic: Sicherheit und Präzision im Fokus

Claude 3 (insbesondere „Opus“) überzeugt durch präzise und sachlich korrekte Antworten. Anthropic legt hohen Wert auf „harmlessness“ und robuste Output-Kontrolle. Das Modell eignet sich besonders für Unternehmen, die auf Sicherheit, Compliance und kontrollierte Sprachmodelle setzen – z. B. im Gesundheits-, Finanz- oder Bildungsbereich. Die Cloud-Standorte (AWS USA) sind datenschutzrechtlich zu prüfen.

2.4. Mistral & Mixtral: Open-Weight-Modelle für flexible Integration

Mistral gehört zur neuen Generation offener KI-Modelle, die auch vollständig on-premise betrieben werden können. Das Modell „Mixtral“ kombiniert mehrere Submodelle im Mixture-of-Experts-Ansatz und liefert beeindruckende Ergebnisse – insbesondere bei Fachtexten, technischem Content oder Code. Mistral ist ideal für Unternehmen mit eigener Infrastruktur, hohen Datenschutzanforderungen oder besonderen Rechenressourcen.

2.5. Meta LLaMA 3: Die Open-Source-Alternative für Entwickler

Meta positioniert LLaMA 3 als Open-Source-Lösung für skalierbare KI-Anwendungen. In Kombination mit Frameworks wie Ollama oder Hugging Face kann es auf lokalen Servern oder in Private-Clouds betrieben werden. Die Textqualität ist solide, aber nicht führend – dafür bietet LLaMA maximale Anpassbarkeit und vollständige Datenhoheit. Interessant für datensensible Branchen oder KI-Startups mit eigenen Trainingsideen.

2.6. Weitere Modelle: Cohere, xAI & Co. im Kurzüberblick

Neben den „großen Fünf“ etablieren sich Modelle wie Cohere (Fokus: semantische Suche, Vektorverständnis) oder xAI von Elon Musk mit Anbindung an X (ehemals Twitter). Diese Modelle spielen in Spezialanwendungen eine Rolle – etwa bei der Analyse unstrukturierter Daten, Textklassifikation oder dem Aufbau interner Wissenssysteme.

3. Vergleichskriterien für den Unternehmenseinsatz

Nicht jedes Modell passt zu jedem Unternehmen. Neben inhaltlicher Qualität zählen im Businesskontext vor allem Datenschutz, technische Integration und wirtschaftliche Tragfähigkeit. Wer KI einführt, sollte die folgenden Kriterien strukturiert vergleichen – idealerweise auf Basis eines konkreten Use-Cases.

3.1. Sprachverständnis & Antwortqualität im Vergleich

Modelle wie GPT-4 und Claude 3 liefern flüssige, stilistisch variable und faktisch präzise Antworten. Claude punktet besonders bei kritischen Themen mit hoher „Verlässlichkeit“ – also geringer Halluzinationsrate. Gemini zeigt seine Stärke bei langen Kontexten und verschachtelten Fragestellungen. LLaMA 3 und Mixtral bieten solide Ergebnisse – bei komplexen Aufgaben aber mit Einschränkungen in Stil und Argumentationstiefe.

Praxisbeispiel:

Wer hochwertige Whitepaper oder Produkttexte erstellen will, fährt mit GPT-4 oder Claude sicherer – bei Preislisten-Importen oder einfachen FAQ-Texten kann Mistral ausreichend sein.

3.2. Kontextlänge & Gedächtnisleistung

Ein unterschätzter Faktor: Wie viel „Denkkontext“ kann das Modell halten? GPT-4 Turbo verarbeitet bis zu 128.000 Tokens, Gemini 1.5 sogar 1 Million – das entspricht einem ganzen Buch. Kleinere Modelle stoßen oft bei längeren Prompts oder komplexen Rückfragen an ihre Grenzen.

Praxisbeispiel:

Ein Modell, das mehrere Seiten aus Verträgen oder Schulungsunterlagen gleichzeitig verarbeiten kann, spart in Support, HR und Legal-Abteilungen täglich Stunden.

3.3. Datenschutz, Sicherheit & Hosting-Optionen

Viele Unternehmen scheitern an diesem Punkt: Wer personenbezogene oder vertrauliche Daten verarbeitet, braucht eine DSGVO-konforme Lösung. GPT-4 über Azure, Mistral, LLaMA oder Modelle mit Self-Hosting-Option (z. B. auf Kubernetes mit GPU) bieten hier volle Kontrolle. Gemini und Claude sind (Stand Frühjahr 2025) nur in US-Rechenzentren verfügbar.

Empfehlung:

Für sensible Anwendungen gilt: Kein Modell ohne klare Datenflusskontrolle und vertragliche Regelung zur Datennutzung.

3.4. API-Zugänglichkeit & Integration in bestehende Systeme

Die Anbindung entscheidet über den Aufwand. GPT-4, Claude und Gemini bieten stabile APIs mit JSON-Kompatibilität. Mistral und LLaMA setzen technisches Know-how voraus, bieten dafür aber maximale Freiheit. Plugins und Tool-APIs (z. B. „Code Interpreter“, „Search“, „PDF Reader“) sind bei GPT-4 bereits produktiv im Einsatz – ein echter Vorteil für hybride Arbeitsprozesse.

Frage:

Möchten Sie das Modell direkt im CRM, CMS oder DMS nutzen? Dann prüfen Sie Schnittstellen, Plugins und SDKs genau.

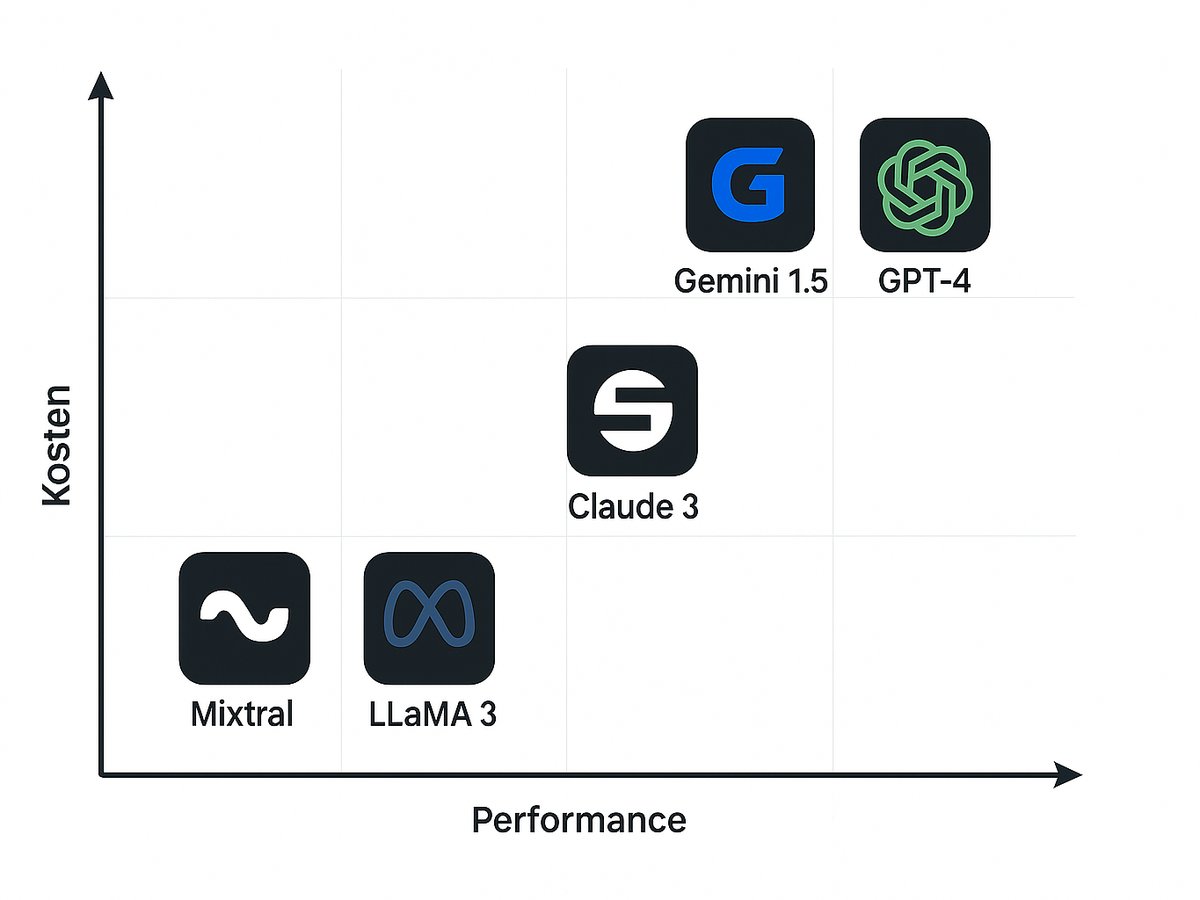

3.5. Preismodelle & Lizenzbedingungen im Überblick

Die Preisstrukturen variieren stark – von pay-per-token (GPT, Claude) über Flatrates (Google Workspace mit Gemini) bis hin zu Open-Source-Lösungen mit Hostingkosten. Faustregel: Wer geringe Volumen mit hoher Qualität braucht, kommt mit API-Modellen gut zurecht. Wer viel lokal verarbeiten will, fährt mit Open-Weight-Modellen günstiger – bei höherem Setup-Aufwand.

Tipp:

Rechnen Sie vor dem Einsatz: 1.000 Token entsprechen ca. 750 Wörtern. Bei GPT-4 kostet ein Chataufruf mit 2.000 Tokens etwa 0,02 €. Multipliziert mit 100.000 Anfragen pro Monat summieren sich schnell spürbare Kosten.

4. Welches Sprachmodell für welchen Anwendungsfall?

Nicht jedes Unternehmen braucht das beste Modell – aber das passende. Je nach Abteilung und Zielsetzung unterscheiden sich Anforderungen massiv. Wir zeigen praxisnah, welches Modell in welchem Use-Case überzeugt – technisch, wirtschaftlich und organisatorisch.

4.1. Marketing & Textautomatisierung

Für hochwertige Inhalte (Blog, Newsletter, SEO-Texte) empfehlen wir GPT-4 oder Claude. Beide liefern stilsichere, kreative und kontextuell passende Vorschläge – auch mehrsprachig. Gemini punktet bei der Analyse bestehender Inhalte und bei Longform-Texten. Mistral oder LLaMA eignen sich bei geringerem Anspruch an Stil oder für interne Textentwürfe.

Beispiel:

Ein mittelständischer Online-Shop nutzt GPT-4 zur Generierung von Produkttexten, FAQs und Social-Media-Inhalten – mit klarer Zeitersparnis im Content-Team.

4.2. Kundenservice & Chatbots

Hier kommt es auf Antwortgeschwindigkeit, Stabilität und Kontexttiefe an. Claude ist besonders robust gegenüber sensiblen Themen, GPT-4 verarbeitet mit Plugins CRM-Daten, Gemini liefert gute Ergebnisse bei FAQ-Systemen. Mistral ist solide für Standarddialoge, wenn Datenschutz oberste Priorität hat und Self-Hosting gewünscht ist.

Beispiel:

Ein IT-Dienstleister ersetzt sein Ticketsystem durch ein KI-Frontend auf Claude-Basis – Anfragen werden vorqualifiziert, priorisiert und in natürlicher Sprache beantwortet.

4.3. Softwareentwicklung & Code-Assistenz

In der Programmierung ist Kontextverarbeitung entscheidend. GPT-4 mit Code Interpreter oder Claude 3 (Opus) liefern nachvollziehbare Vorschläge, refaktorisieren bestehende Funktionen oder kommentieren Code. Mixtral glänzt mit Performance bei technischer Dokumentation und ist kostenneutral auf eigenen Servern nutzbar.

Beispiel:

Ein Entwicklerteam nutzt GPT-4 direkt in VS Code zur Vorschlagsgenerierung, Dokumentationserstellung und Unit-Test-Erzeugung – mit über 20 % Produktivitätsgewinn.

4.4. Wissensmanagement & interne Automatisierung

Wenn es darum geht, interne Dokumente auszuwerten, Richtlinien zu erklären oder auf Basis von Wissensdatenbanken zu antworten, sind Gemini und GPT-4 erste Wahl. Beide können große Textmengen verarbeiten und mit externer Suche verknüpft werden. LLaMA eignet sich als Inhouse-Lösung mit Zugriff auf lokale Dateien und bei Bedarf vollständiger Offline-Nutzung.

Beispiel:

Ein Beratungsunternehmen stellt seinem Team ein internes KI-Tool zur Verfügung, das auf Claude 3 basiert und über semantische Suche auf alle Projektdokumente zugreift.

5. Fazit: Das richtige Modell für Ihr Unternehmen finden

Die Vielfalt an Sprachmodellen ist groß – und genau darin liegt die Chance. Denn nicht jedes Unternehmen braucht das leistungsstärkste Modell, sondern das passendste. Entscheidend sind immer drei Fragen:

- Was ist der konkrete Use-Case?

- Wie sensibel sind die Daten?

- Wie hoch ist das erwartete Nutzungsvolumen?

Für Unternehmen mit strengen Datenschutzanforderungen oder Wunsch nach Inhouse-Betrieb bieten Mistral, LLaMA 3oder andere Open-Weight-Modelle die volle Kontrolle – bei überschaubarem Aufwand. Wer schnelle Ergebnisse für Marketing, Kommunikation oder Vertrieb benötigt, greift zu GPT-4 Turbo oder Claude 3 Opus – idealerweise via DSGVO-konformer Hosting-Plattform (z. B. Azure, AWS Frankfurt). Für sehr große Dokumentenmengen und komplexe Kontextverarbeitung ist Gemini 1.5 im Vorteil – sofern der rechtliche Rahmen passt.

Unsere Empfehlung: Testen Sie gezielt. Starten Sie mit einem Pilotprojekt in einem klar abgegrenzten Bereich. So lässt sich ohne Risiko ermitteln, welches Modell Ihnen echten Mehrwert bringt – inhaltlich, technisch und wirtschaftlich. Die North IT Group unterstützt Sie bei Auswahl, Integration und Betrieb des für Sie optimalen KI-Systems.

6. North IT Group: Ihre Experten für KI-Integration und Betrieb

Die Einführung eines KI-Sprachmodells ist kein Plug-and-Play-Projekt. Es braucht klare Ziele, eine belastbare technische Infrastruktur und ein Verständnis für Chancen und Grenzen der Modelle. Genau hier setzt die North IT Group an.

Wir beraten mittelständische Unternehmen bei der Auswahl des passenden Sprachmodells, evaluieren technische Voraussetzungen und setzen Integrationen um – ob als API in bestehende Systeme, als internes Assistenztool oder als vollständig lokales Deployment auf eigener Infrastruktur.

Unser Vorgehen ist hands-on und lösungsorientiert:

- Analyse Ihrer Use-Cases mit Fokus auf Business Impact

- Auswahl & Test geeigneter Modelle (inkl. Datenschutz-Check)

- Integration in bestehende Systeme (CRM, CMS, DMS, Intranet etc.)

- Schulung Ihrer Teams im praktischen Umgang mit der KI

- Betrieb & Wartung auf Wunsch durch unser Entwicklerteam

Ob Pilotprojekt oder langfristiger Rollout – wir begleiten Sie mit technischer Präzision und wirtschaftlichem Augenmaß. Sichern Sie sich Innovationsvorsprung und Effizienzgewinne mit einer KI-Lösung, die wirklich zu Ihnen passt.

Rufen Sie uns gerne unter 015678573735 an oder schreiben Sie uns office@northitgroup.com .